原FastDFS介绍及安装

一、FastDFS介绍

1.1 介绍

FastDFS 是一个 C 语言实现的开源轻量级分布式文件系统,支持 Linux、FreeBSD、AID 等 Unix系统,解决了大数据存储和读写负载均衡等问题,适合存储 4KB~500MB 之间的小文件,如图片网站、短视频网站、文档、app 下载站等,UC、京东、支付宝、迅雷、酷狗等都有使用,其中 UC 基于 FastDFS 向用户提供网盘、广告和应用下载的业务的存储服务 FastDFS 与 MogileFS、HDFS、TFS 等都不是系统级的分布式文件系统,而是应用级的分布式文件存储服务。

1.2 架构

FastDFS服务有三个角色:跟踪服务器(Tracker Server)、存储服务器(storage server)和客户端(client)

Tracker Server: 跟踪服务器,主要做调度工作,起到均衡的作用;负责管理所有的 storage server 和 group,每个 storage 在启动后会连接 Tracker,告知自己所属 group 等信息,并保持周期性心跳, Tracker根据storage心跳信息,建立group--->[storage server list]的映射表;tracker管理的元数据很少,会直接存放在内存;tracker 上的元信息都是由 storage 汇报的信息生成的,本身不需要持久化任何数据,tracker 之间是对等关系,因此扩展 tracker 服务非常容易,之间增加 tracker服务器即可,所有tracker都接受stroage心跳信息,生成元数据信息来提供读写服务(与 其他 Master-Slave 架构的优势是没有单点,tracker 也不会成为瓶颈,最终数据是和一个可用的 Storage Server进行传输的)

Storage Server: 存储服务器,主要提供容量和备份服务;以 group 为单位,每个 group 内可以包含多台storage server,数据互为备份,存储容量空间以group内容量最小的storage为准;建 议group内的storage server配置相同;以group为单位组织存储能够方便的进行应用隔离、负载均衡和副本数定制;缺点是 group 的容量受单机存储容量的限制,同时 group 内机器坏掉,数据 恢复只能依赖 group 内其他机器重新同步(坏盘替换,重新挂载重启 fdfs_storaged 即可)

1.3 Group存储策略

多个group之间的存储方式有3种策略:round robin(轮询)、load balance(选择最大剩余空间的组上传文件)、specify group(指定group上传)

group 中 storage 存储依赖本地文件系统,storage 可配置多个数据存储目录,磁盘不做 raid, 直接分别挂载到多个目录,将这些目录配置为 storage 的数据目录即可

storage 接受写请求时,会根据配置好的规则,选择其中一个存储目录来存储文件;为避免单 个目录下的文件过多,storage 第一次启时,会在每个数据存储目录里创建2级子目录,每级256个,总共 65536 个,新写的文件会以 hash 的方式被路由到其中某个子目录下,然后将文件数据直 接作为一个本地文件存储到该目录中

1.4 工作流程

1.4.1 上传

FastDFS向使用者提供基本文件访问接口,比如upload、download、append、delete等,以客户端库的方式提供给用户使用。

Storage Server会定期的向Tracker Server发送自己的存储信息。当Tracker Server Cluster中的Tracker Server不止一个时,各个Tracker之间的关系是对等的,所以客户端上传时可以选择任意一个Tracker。

当Tracker收到客户端上传文件的请求时,会为该文件分配一个可以存储文件的group,当选定了group后就要决定给客户端分配group中的哪一个storage server。当分配好storage server后,客户端向storage发送写文件请求,storage将会为文件分配一个数据存储目录。然后为文件分配一个fileid,最后根据以上的信息生成文件名存储文件。

FastDFS上传时序图:

1.4.2 同步

写文件时,客户端将文件写至group内一个storage server即认为写文件成功,storage server写完文件后,会由后台线程将文件同步至同group内其他的storage server。

每个storage写文件后,同时会写一份binlog,binlog里不包含文件数据,只包含文件名等元信息,这份binlog用于后台同步,storage会记录向group内其他storage同步的进度,以便重启后能接上次的进度继续同步;进度以时间戳的方式进行记录,所以最好能保证集群内所有server的时钟保持同步。

storage的同步进度会作为元数据的一部分汇报到tracker上,tracke在选择读storage的时候会以同步进度作为参考。

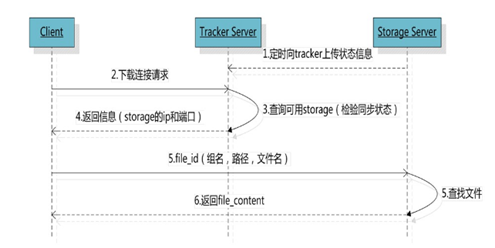

1.4.3 下载

客户端uploadfile成功后,会拿到一个storage生成的文件名,接下来客户端根据这个文件名即可访问到该文件。跟upload file一样,在downloadfile时客户端可以选择任意tracker server。tracker发送download请求给某个tracker,必须带上文件名信息,tracke从文件名中解析出文件的group、大小、创建时间等信息,然后为该请求选择一个storage用来服务读请求。

FastDFS下载时序图:

二、FastDFS安装

2.1 下载安装libfastcommon

- 下载libfastcommon

wget https://github.com/happyfish100/libfastcommon/archive/V1.0.38.tar.gz - 解压

tar -zxvf V1.0.38.tar.gz cd libfastcommon-1.0.38 - 编译安装

./make.sh ./make.sh install2.2 安装fastDFS

- 下载

wget https://github.com/happyfish100/fastdfs/archive/V5.10.tar.gz - 解压

tar -zxvf V5.10.tar.gz cd fastdfs-5.10 - 编译安装

./make.sh ./make.sh install - Fastdfs的文件目录

A、服务脚本: /etc/init.d/fdfs_storaged /etc/init.d/fdfs_trackerd B、配置文件模板: /etc/fdfs/client.conf.sample /etc/fdfs/storage.conf.sample /etc/fdfs/tracker.conf.sample

2.3 配置跟踪器(Tracker)

- 进入 /etc/fdfs,复制 FastDFS 跟踪器样例配置文件 tracker.conf.sample,并重命名为 tracker.conf。

cd /etc/fdfs cp tracker.conf.sample tracker.conf vim tracker.conf - 编辑tracker.conf ,加粗的需要修改下,其它的默认即可。

#配置文件是否不生效,false 为生效 disabled=false #提供服务的端口 port=22122 #Tracker 数据和日志目录地址(根目录必须存在,子目录会自动创建)

base_path=/home/data/fastdfs/tracker

http.server_port=80

- 创建tracker基础数据目录,即base_path对应的目录

mkdir -p /home/data/fastdfs/tracker - 防火墙中打开跟踪端口(默认的22122)

vim /etc/sysconfig/iptables最下面添加一行:-A INPUT -m state --state NEW -m tcp -p tcp --dport 22122 -j ACCEPT重启iptables:service iptables restart - 启动Tracker

初次成功启动,会在 /home/data/fdfsdfs/tracker/ (配置的base_path)下创建 data、logs 两个目录。

可以用这种方式启动:

/etc/init.d/fdfs_trackerd startservice fdfs_trackerd start查看 FastDFS Tracker 是否已成功启动 ,22122端口正在被监听,则算是Tracker服务安装成功。netstat -unltp|grep fdfs关闭Tracker命令:service fdfs_trackerd stop2.4 配置存储(Storage)

- 进入 /etc/fdfs 目录,复制 FastDFS 存储器样例配置文件 storage.conf.sample,并重命名为 storage.conf

# cd /etc/fdfs # cp storage.conf.sample storage.conf # vim storage.conf - 编辑storage.conf, 加粗的需要修改,其它的默认即可。

#配置文件是否不生效,false 为生效

disabled=false#指定此 storage server 所在 组(卷)group_name=group1#storage server 服务端口port=23000#心跳间隔时间,单位为秒 (这里是指主动向 tracker server 发送心跳)heart_beat_interval=30#Storage 数据和日志目录地址(根目录必须存在,子目录会自动生成)

base_path=/home/data/fastdfs/storage

#存放文件时 storage server 支持多个路径。这里配置存放文件的基路径数目,通常只配一个目录。store_path_count=1

#逐一配置 store_path_count 个路径,索引号基于 0。

#如果不配置 store_path0,那它就和 base_path 对应的路径一样。store_path0=/home/data/fastdfs/file

#FastDFS 存储文件时,采用了两级目录。这里配置存放文件的目录个数。

#如果本参数只为 N(如: 256),那么 storage server 在初次运行时,会在 store_path 下自动创建 N * N 个存放文件的子目录。subdir_count_per_path=256

#tracker_server 的列表 ,会主动连接 tracker_server

#有多个 tracker server 时,每个 tracker server 写一行tracker_server=192.168.1.161:22122

#允许系统同步的时间段 (默认是全天) 。一般用于避免高峰同步产生一些问题而设定。sync_start_time=00:00sync_end_time=23:59

#访问端口http.server_port=80

- 创建Storage基础数据目录,对应base_path目录

mkdir -p /home/data/fastdfs/storage这是配置的store_path0路径mkdir -p /home/data/fastdfs/file - 防火墙中打开存储器端口(默认的 23000)

vim /etc/sysconfig/iptables添加如下端口行:-A INPUT -m state --state NEW -m tcp -p tcp --dport 23000 -j ACCEPT重启防火墙:service iptables restart - 启动 Storage

启动Storage前确保Tracker是启动的。初次启动成功,会在 /home/data/fastdfs/storage 目录下创建 data、 logs 两个目录。

可以用这种方式启动

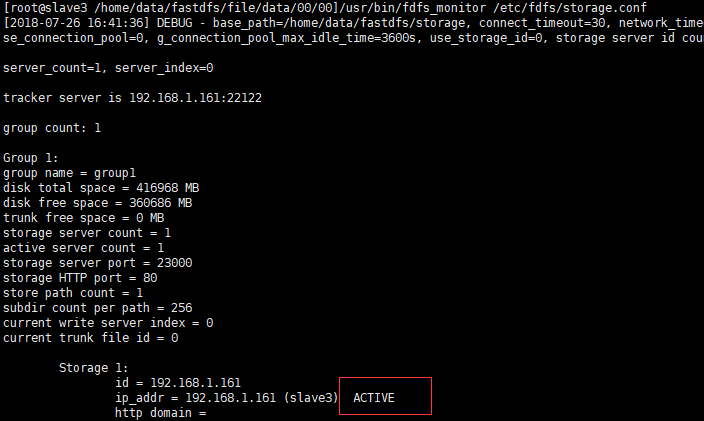

/etc/init.d/fdfs_storaged startservice fdfs_storaged start查看Storage和Tracker是否在通信:/usr/bin/fdfs_monitor /etc/fdfs/storage.conf